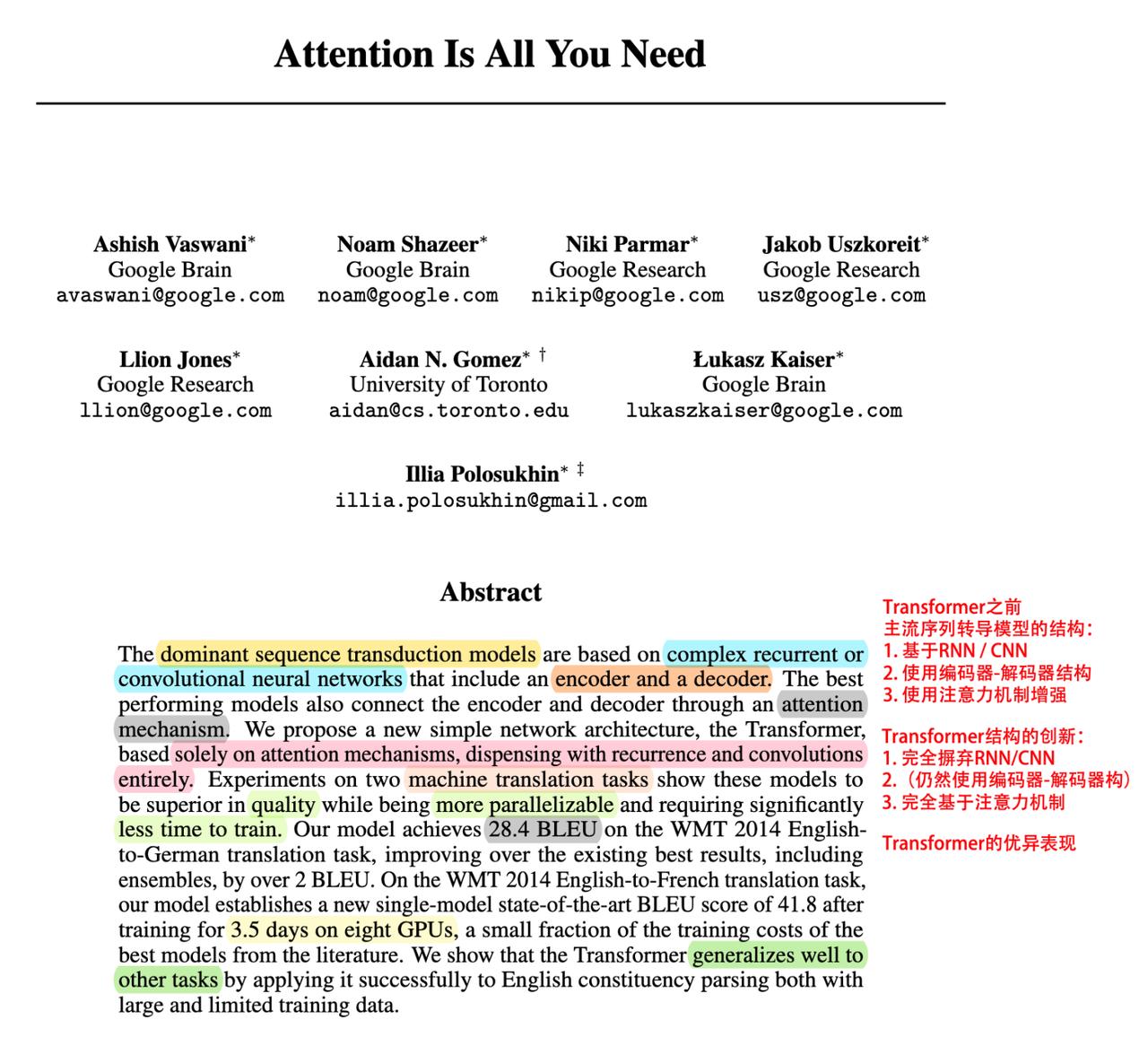

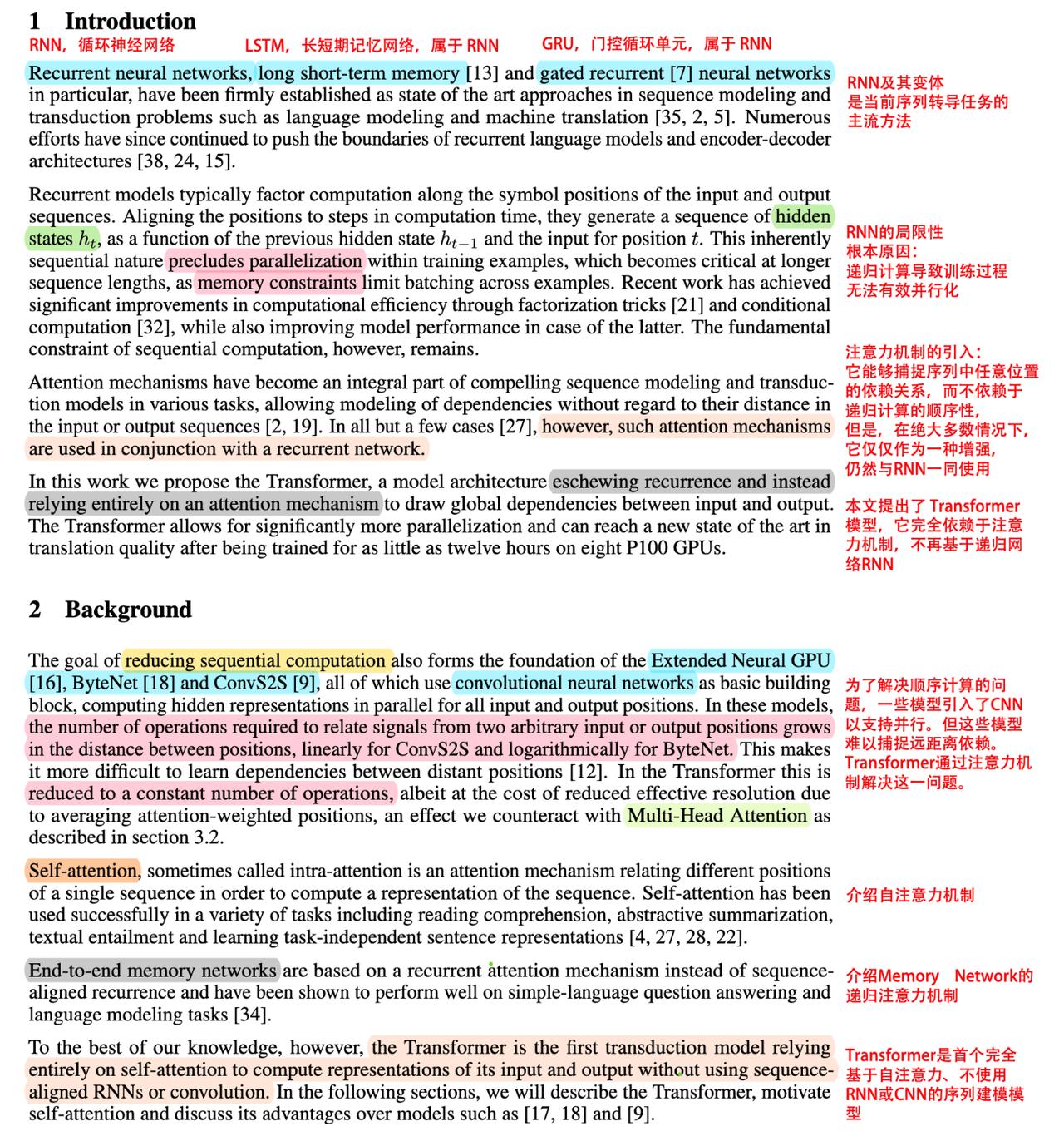

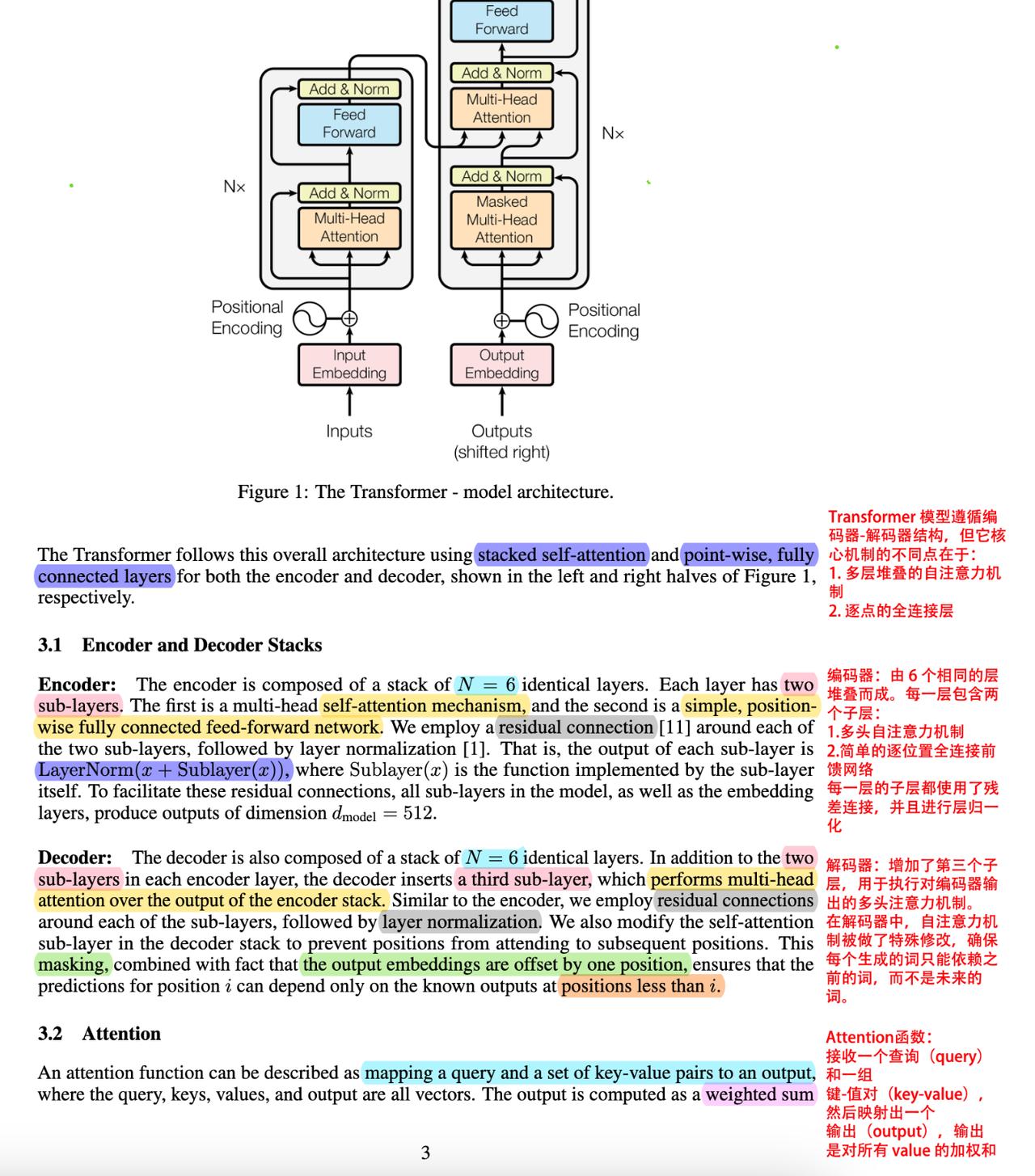

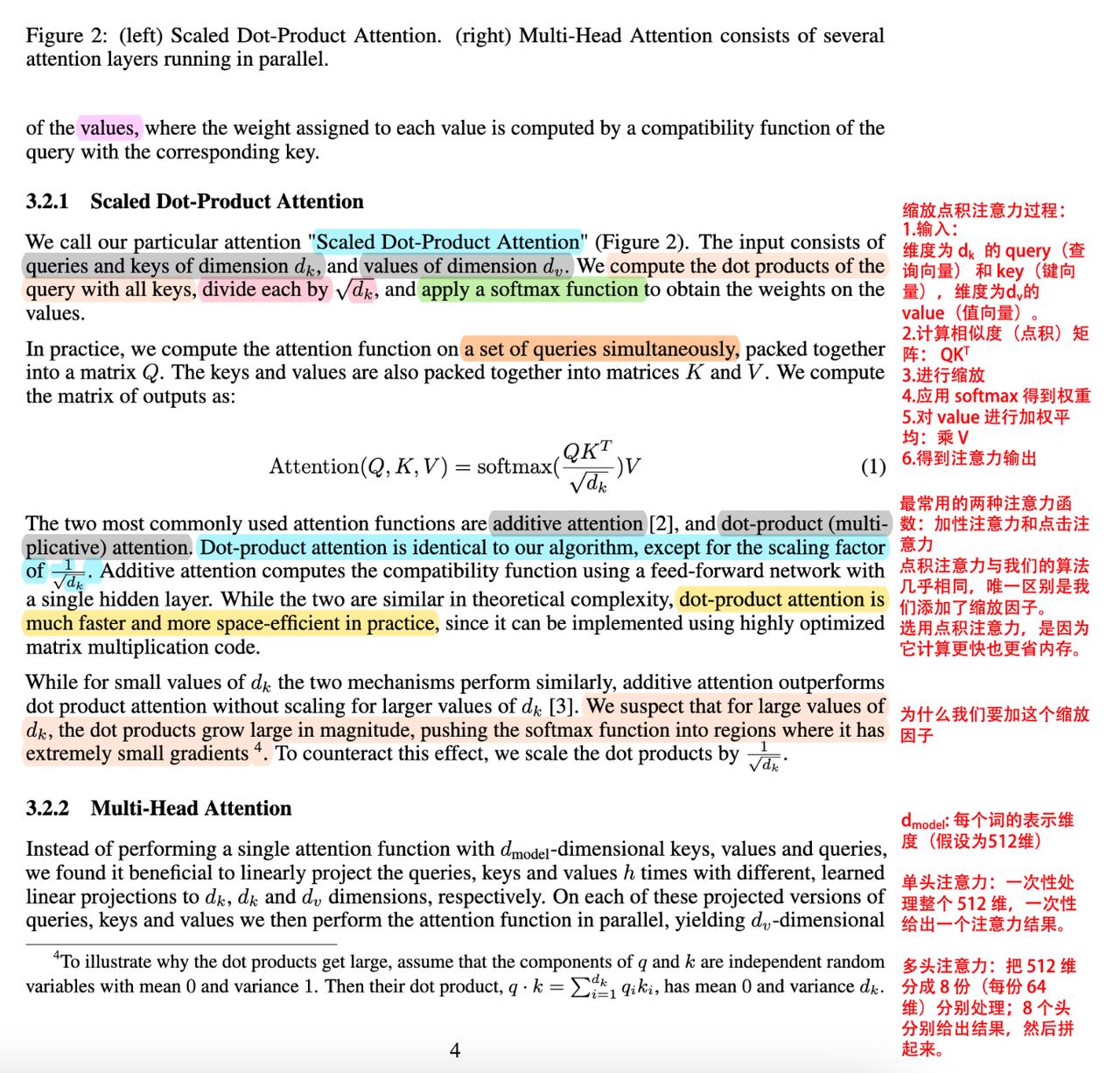

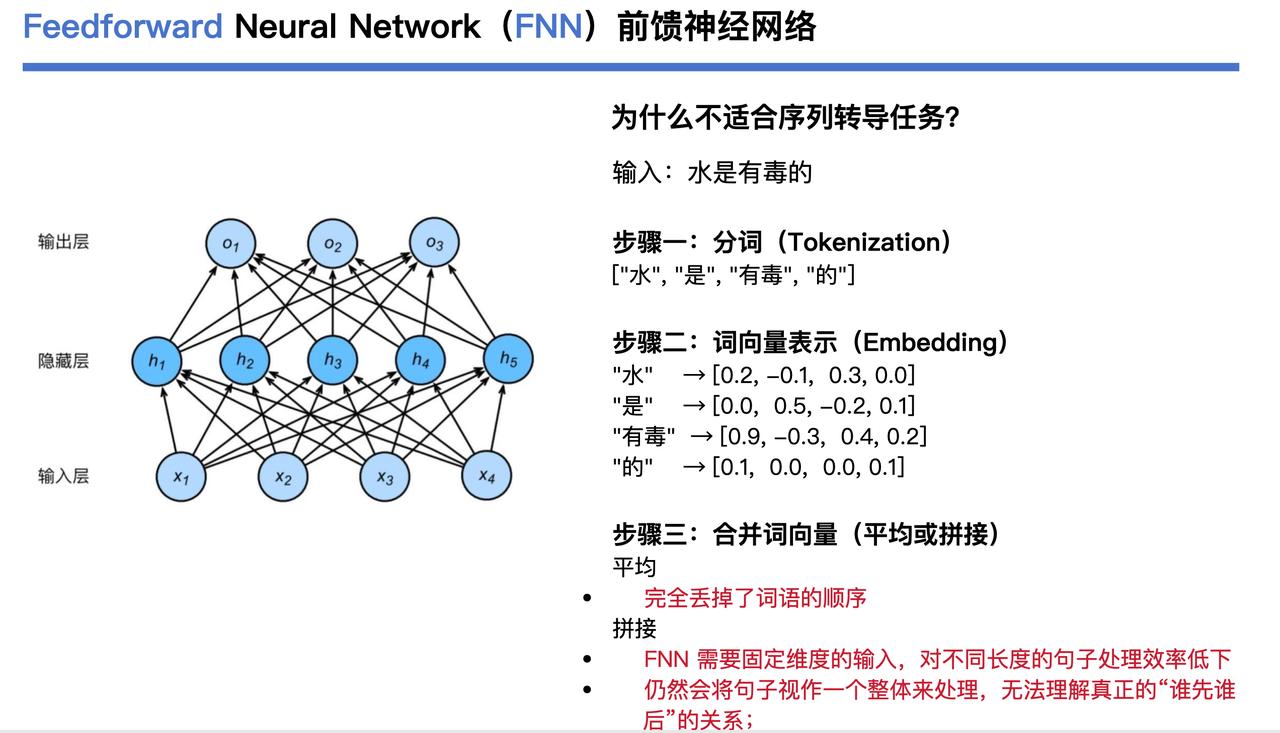

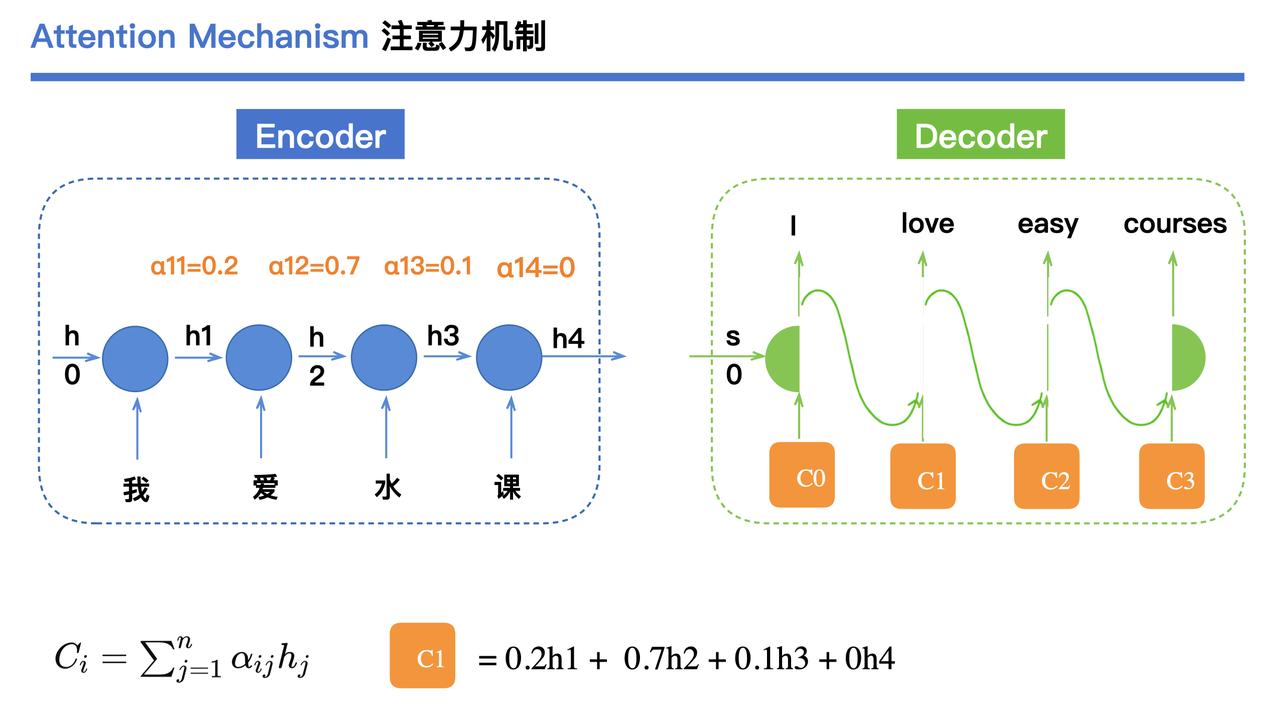

笔记版《Attention is all you need》论文+配套讲解PPT。 资料出自up主“堂吉诃德拉曼查的英豪”,内容很系统,适合刚入门也适合查漏补缺。 重点内容包括: 1. 注释版论文:直接在原文PDF上做了中文标注,解释了核心概念、自注意力的计算流程、模型结构图、训练细节等等,哪段重点、哪里容易误解都标得很清楚。看着这版PDF,基本不用反复查资料了。 2. 讲解PPT:PPT从背景讲起,把Transformer为什么要这么设计一步步讲清楚,还搭配图示复现了论文核心结构,比如Encoder-Decoder分工、多头注意力细节、位置编码的逻辑等,节奏适中不费脑。 一看论文就卡壳的小伙伴,能降低Transformer的理解门槛。建议搭配原论文一起食用,效果更佳。 配套视频名为:“《Attention is all you need》论文解读及Transformer架构详细介绍”,大家可以自行搜索。 GitHub地址:github.com/huangyf2013320506/bilibili_repository