大模型依赖“启发式规则包”,但是灵活性极差,远不如人的逻辑体系好

1. WSJ报导,我们终于知道大模型如何“思考”了——基本没啥思考。

2. 大模型很像无所不知的AGI,奥数题都会。内部是黑盒子,人们不知道大模型是怎么给出回答的,是很多矩阵系数在算,很难理解。研究者开发了工具去跟踪内部系数,部分解释了大模型的运作逻辑。它学习了极多人类给的知识,然后内部建立了很多“启发式规则包”,也就是回答问题的捷径。这些规则包是人类无法想象的,非常杂乱。

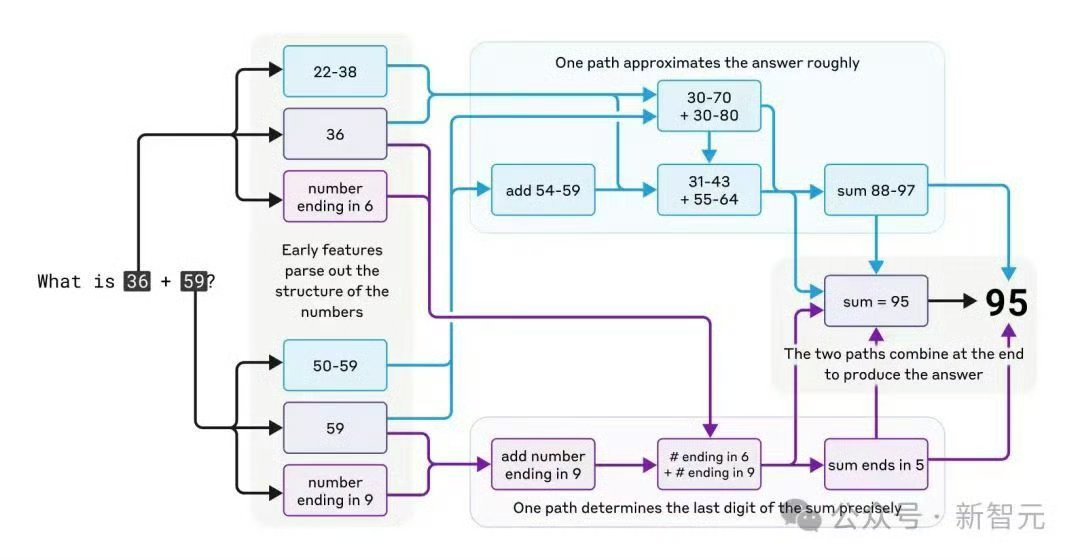

3. 例如大模型会做加法乘法,但不是按人类的简洁规则。如对200-210之间是一个套路,换个区间又是一种套路。Anthropic发现,大模型做加法是两条路线,如36+59,一条路得出尾数是5,一条路得出结果区间是88-97,最后只有95符合。换个组合又是另外的搞法。

4. 大模型能够告诉人类,加法和乘法的正确规则。但自己无法理解,不会用。它训练出自己的古怪捷径,这样的捷径到处都是,训练集中的问题回答得很好。因为它系数多,也算是有个规则网络,就是非常乱。

5. 大问题是,这等于建立了很多“做题窍门”,但是不理解原理。这种窍门还是自己闭门造车捣鼓出来的,最大问题是灵活性极差,问题改一点点,临时性的启发式规则就失灵了。这导致大模型做数学题测试集表现很好,奥数金牌,但是换点形式、新题,就很糟糕。

6. 大模型像是勤奋的文科生,但没有逻辑理解力,背书久了“其义自现”,自己建立了复杂的文科式规则。就像古代中国,每个文科生建立的内部规则都不一样,经常混战。它最拿手的套路就是“文字关联”,看见一个文字组合就知道是关于什么的。还会建立隐藏的关联,如一类问题会建立内部的节点,来对应某种概率性的发现。

7. 这毛病很难治。我们很难相信,大模型用这些杂乱又不灵活的启发式规则包,海量的临时性规则,居然能实现比人类还聪明的AGI。现在已经可以得出结论,它不可能比人类聪明,甚至本底智能很差。再训练、多思考,也就是建立更多闭门造车的答题捷径规则包,毫无人类逻辑系统的美感。

8. 这种杂凑的智能,没有深度,会出错,幻觉严重。长处是领域丰富什么都能说,不怕累,对训练的问题表现好。这样的特性,已经可以做AI应用了,但不能指望太高。注意这是说基于Transformer的大模型,其它类型的AI在特定领域逻辑能力可能超过人,但不是通用的。