AI太耗能,这事儿几乎没人反对。但有一批研究者,正在用几十年前的“老思路”,尝试开辟全新节能路径——让计算“倒着跑”。 这个思路是,绝大多数计算机每次运行都会丢失信息,比如2+2=4,结果只有4,原本输入的两个2没了。这种“删数据”的过程会不可避免地发热。早在1961年,IBM的物理学家Landauer就提出:每删一比特数据,都会损失一定的能量,这事儿无解,是物理定律。 那怎么办?Landauer当时觉得,唯一的解法是“别删数据”,但这样会让内存迅速被填满,不现实。他一度认为这是死路一条。 但他的同事Charles Bennett后来提出另一个方案:每次计算完后,把结果记住,再“反向运行”一遍,把中间过程恢复后清空,就像《格林童话》中,汉塞尔和格蕾特捡回面包屑的故事一样,不留痕迹。 而这种方式,叫Uncomputation,等于既保住了结果,也不丢数据,还节能。但问题是,这种方法要花双倍时间,依然难以落地。 直到上世纪90年代,MIT工程师们开始动手做原型芯片,试图从硬件层面解决发热问题。Michael Frank【图2】也加入了这项工作,成为可逆计算最坚定的推动者之一。但当时芯片技术突飞猛进,没人关心这种“慢又麻烦”的替代方案。Frank甚至一度放弃,转去开了家网吧。[吐舌] 现在情况变了。 随着传统芯片快到极限,新的方法反而更有吸引力。2022年,剑桥大学的研究者Hannah Earley精确计算出:只要计算够慢,可逆计算可以大幅降低发热。她和Frank一起创办了Vaire Computing,准备把这事做成商品。 特别是在AI领域,这种方法可能意义重大: - AI计算常用并行结构,不需要太快; - 多芯片慢速运行,节能效果反而更好; - 发热低,可以密集布置,省空间和散热成本。 几十年的理论,如今终于逼近落地。哥本哈根大学的Mogensen评价:真正看到可逆计算芯片投产,将是这个领域“最令人兴奋的一刻”。 感兴趣的小伙伴可以阅读原文:-can-ai-researchers-save-energy-by-going-backward-20250530/

![这ai太逼真吗?[赞][赞]ai](http://image.uczzd.cn/422974456033376523.jpg?id=0)

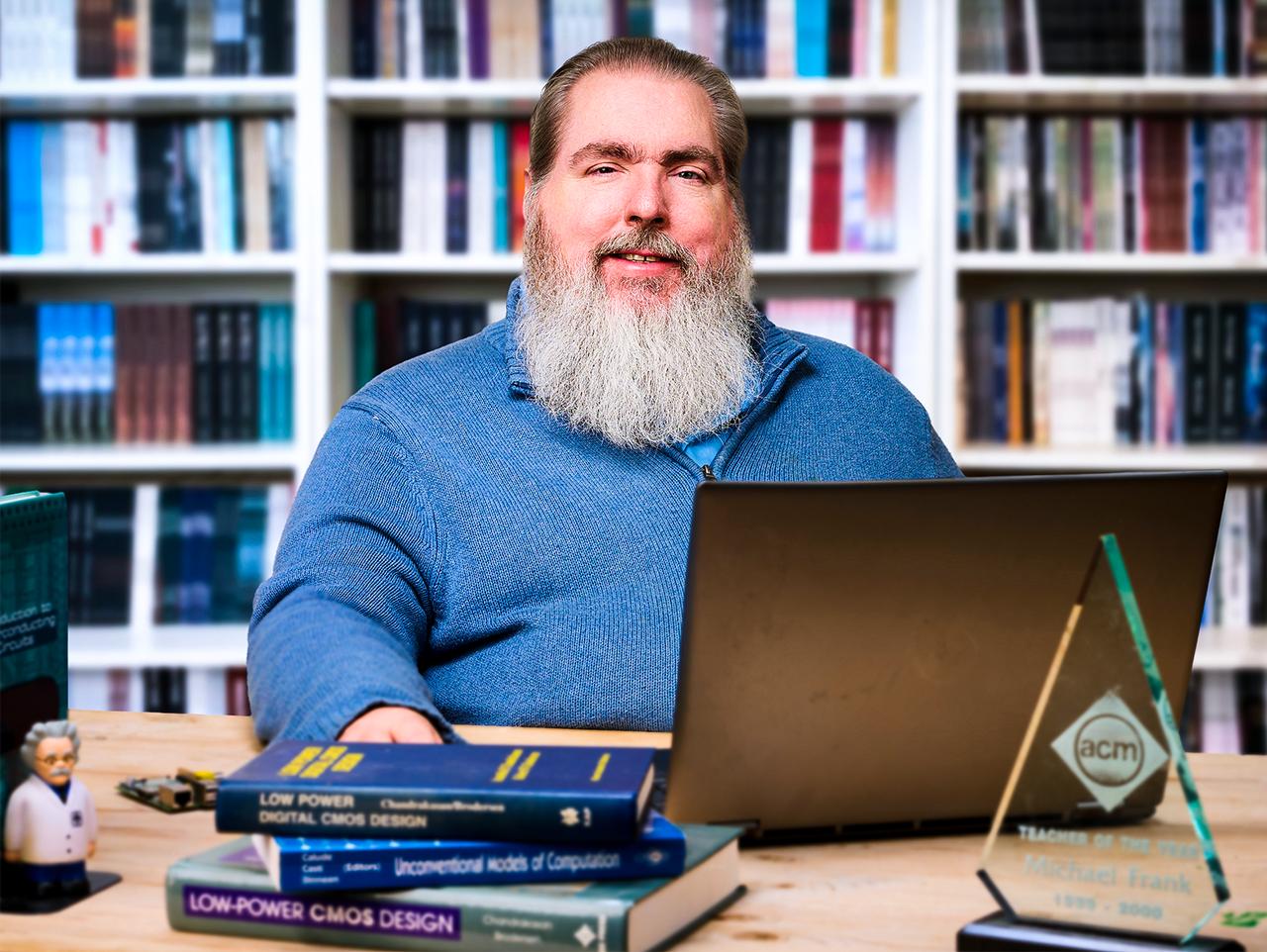

![不得不承认,现在的Ai真是太牛了。[赞][赞]](http://image.uczzd.cn/15735454032649033129.jpg?id=0)